lnb영역

수강신청

컨텐츠 내용

- 수강신청

- 과정정보

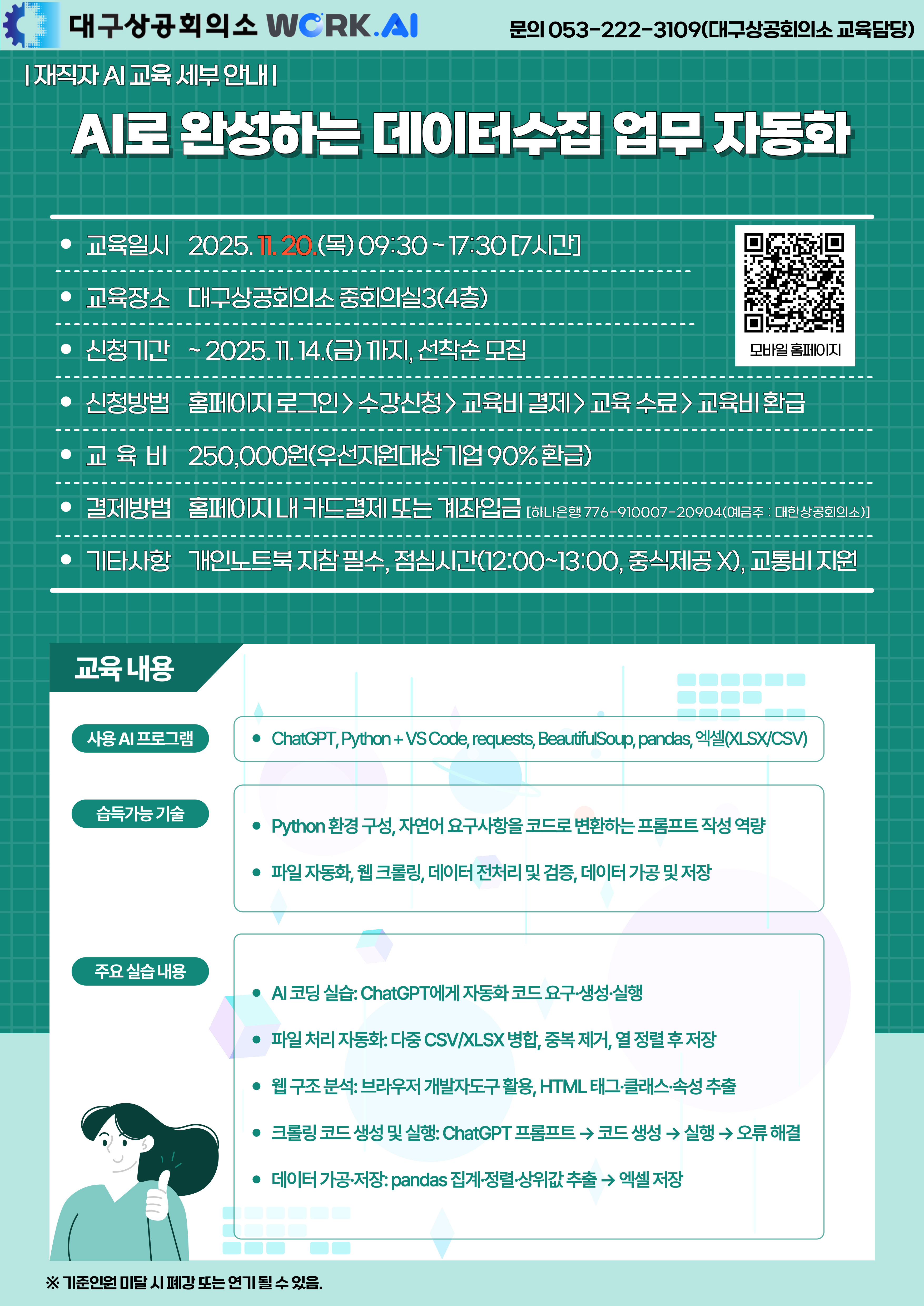

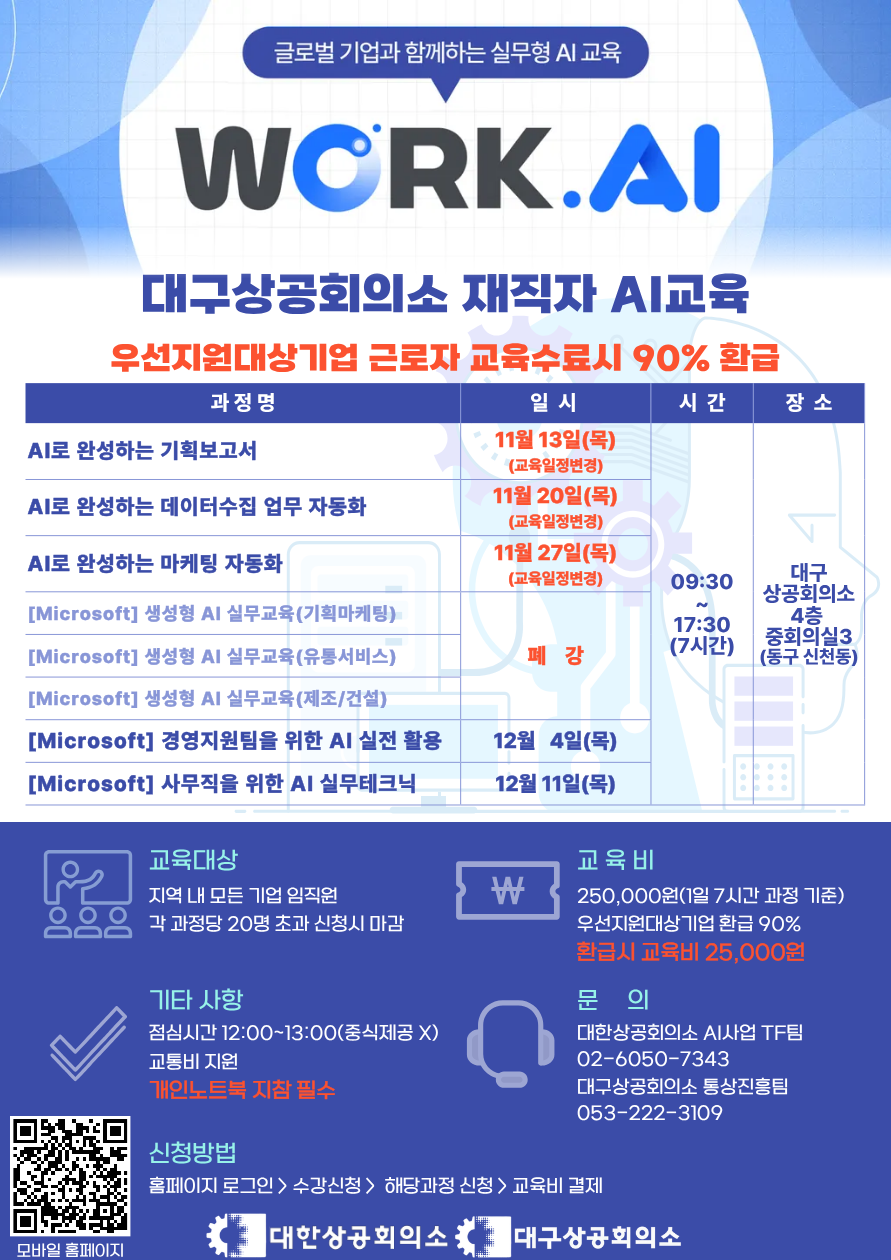

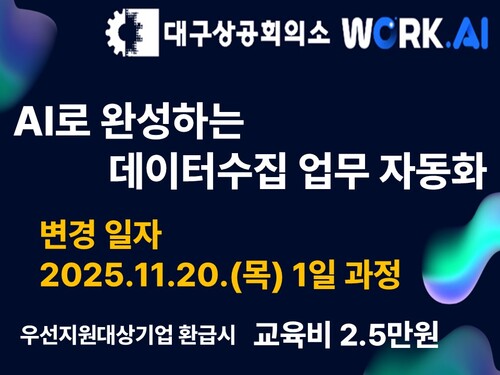

[대구상공회의소] AI로 완성하는 데이터수집 업무 자동화

□ 과정소개

□ 학습목표

○ 실무 자동화에 필요한 Python 핵심 문법과 개발 환경 구성 절차를 이해한다.

○ ChatGPT를 활용하여 크롤링·데이터 가공·파일 처리 등 반복 업무를 생성·수정·디버깅하는 방법을 습득한다.

○ 웹 페이지 구조(HTML·Selector)를 파악하고 requests·BeautifulSoup·pandas 등 라이브러리를 활용해 데이터 수집–정제–저장 과정을 실습한다.

○ 수집 데이터를 엑셀 파일로 가공·저장하여 보고서/기획 자료의 기초 데이터로 활용한다.

○ 업무 자동화와 Python 기초

- Python의 특징과 업무 자동화 사례 : Python이 업무 자동화에 널리 쓰이는 이유를 이해한다.

- Python 및 VS Code 설치 : 파이썬 코드를 작성하고 실행하기 위한 기본 환경을 구축한다.

- AI와 함께하는 코딩(Vibe Coding) : 코드를 직접 짜는 대신, AI에게 명확히 요구하여 코드를 생성하는 개념을 학습한다.

○ 파일 자동화 & 엑셀 통합[ChatGPT를 활용하여 파일 일괄처리·통합 스크립트 만들기]

- 반복 파일 작업 자동화 개요를 이해한다(이름 일괄 변경, 폴더 병합, 확장자 필터링).

- 자연어 요구사항을 파일 처리 코드로 변환하는 프롬프트 패턴을 학습한다(입력 폴더/출력 규칙/예외).

- pandas로 CSV/XLSX 다건 병합·중복 제거·열 정렬을 실습한다(스키마 불일치 간단 처리 포함).

- 결과를 단일 엑셀로 저장하고 시트 분리/날짜 접미사 등 저장 규칙을 실습한다.

○ ChatGPT 활용 웹 크롤링 실습[웹 페이지 구조 분석 (HTML 기초)]

- 브라우저 개발자도구로 요소(태그·클래스·속성) 확인·추출 방법을 실습한다.

- requests+BeautifulSoup를 활용해 리스트/상세 페이지에서 필드를 수집하는 절차를 실습한다(단순 페이지네이션 포함).

- 수집 데이터의 중복 제거·결측 처리와 기본 검증 절차를 실습한다.

- 크롤링 에티켓(robots.txt 확인·요청 간 지연)과 저작권·개인정보 유의사항을 숙지한다.

○ ChatGPT 활용 웹 크롤링 실습[ChatGPT로 크롤링 코드생성 및 실행]

- 크롤링 코드 생성 프롬프트 작성 : 목표 웹사이트와 원하는 데이터를 명시하여 ChatGPT에 코드 생성을 요청한다.

- 생성된 코드 분석 및 실행 : ChatGPT가 만들어준 코드를 편집기에 붙여넣고, 각 코드 라인의 의미를 파악한 후 실행한다.

- 오류 해결(디버깅) 기초 : 코드 실행 시 발생하는 간단한 오류 메시지를 읽고, ChatGPT의 도움을 받아 해결하는 방법을 실습한다.

○ 데이터 가공 및 활용[크롤링 데이터 가공 및 엑셀 파일 저장]

- pandas를 활용해 집계·정렬·상위 N 등 리포트용 표를 실습한다.

- 정리된 데이터를 엑셀 파일로 자동 저장하는 코드를 ChatGPT로 생성하고 실행한다.

- 개인 업무에 맞춘 적용 시나리오(예: 주간 상품 현황·경쟁사 공지 수집 결과)를 정리한다.

○ ChatGPT를 활용하여 크롤링·데이터 가공·파일 처리 등 반복 업무를 생성·수정·디버깅하는 방법을 습득한다.

○ 웹 페이지 구조(HTML·Selector)를 파악하고 requests·BeautifulSoup·pandas 등 라이브러리를 활용해 데이터 수집–정제–저장 과정을 실습한다.

○ 수집 데이터를 엑셀 파일로 가공·저장하여 보고서/기획 자료의 기초 데이터로 활용한다.

○ 업무 자동화와 Python 기초

- Python의 특징과 업무 자동화 사례 : Python이 업무 자동화에 널리 쓰이는 이유를 이해한다.

- Python 및 VS Code 설치 : 파이썬 코드를 작성하고 실행하기 위한 기본 환경을 구축한다.

- AI와 함께하는 코딩(Vibe Coding) : 코드를 직접 짜는 대신, AI에게 명확히 요구하여 코드를 생성하는 개념을 학습한다.

○ 파일 자동화 & 엑셀 통합[ChatGPT를 활용하여 파일 일괄처리·통합 스크립트 만들기]

- 반복 파일 작업 자동화 개요를 이해한다(이름 일괄 변경, 폴더 병합, 확장자 필터링).

- 자연어 요구사항을 파일 처리 코드로 변환하는 프롬프트 패턴을 학습한다(입력 폴더/출력 규칙/예외).

- pandas로 CSV/XLSX 다건 병합·중복 제거·열 정렬을 실습한다(스키마 불일치 간단 처리 포함).

- 결과를 단일 엑셀로 저장하고 시트 분리/날짜 접미사 등 저장 규칙을 실습한다.

○ ChatGPT 활용 웹 크롤링 실습[웹 페이지 구조 분석 (HTML 기초)]

- 브라우저 개발자도구로 요소(태그·클래스·속성) 확인·추출 방법을 실습한다.

- requests+BeautifulSoup를 활용해 리스트/상세 페이지에서 필드를 수집하는 절차를 실습한다(단순 페이지네이션 포함).

- 수집 데이터의 중복 제거·결측 처리와 기본 검증 절차를 실습한다.

- 크롤링 에티켓(robots.txt 확인·요청 간 지연)과 저작권·개인정보 유의사항을 숙지한다.

○ ChatGPT 활용 웹 크롤링 실습[ChatGPT로 크롤링 코드생성 및 실행]

- 크롤링 코드 생성 프롬프트 작성 : 목표 웹사이트와 원하는 데이터를 명시하여 ChatGPT에 코드 생성을 요청한다.

- 생성된 코드 분석 및 실행 : ChatGPT가 만들어준 코드를 편집기에 붙여넣고, 각 코드 라인의 의미를 파악한 후 실행한다.

- 오류 해결(디버깅) 기초 : 코드 실행 시 발생하는 간단한 오류 메시지를 읽고, ChatGPT의 도움을 받아 해결하는 방법을 실습한다.

○ 데이터 가공 및 활용[크롤링 데이터 가공 및 엑셀 파일 저장]

- pandas를 활용해 집계·정렬·상위 N 등 리포트용 표를 실습한다.

- 정리된 데이터를 엑셀 파일로 자동 저장하는 코드를 ChatGPT로 생성하고 실행한다.

- 개인 업무에 맞춘 적용 시나리오(예: 주간 상품 현황·경쟁사 공지 수집 결과)를 정리한다.

□ 교육대상

○ 파이썬 코드를 직접 작성하는 데 부담을 느끼지만, 코드 생성을 통해 반복 업무를 자동화하고 싶은 중소기업 재직자

○ 마케팅, 기획, 영업 직군 등에서 시장 조사, 경쟁사 분석 등을 위해 웹 데이터 수집이 필요한 실무자

○ 마케팅, 기획, 영업 직군 등에서 시장 조사, 경쟁사 분석 등을 위해 웹 데이터 수집이 필요한 실무자

| 차시 | 일시 | 강의명 |

|---|---|---|

| 강의 목차가 없습니다. | ||